Um dos objetivos da pesquisa em Inteligência Artificial (IA) é o desenvolvimento da IA forte (strong AI), também chamada de AGI (Inteligência Artificial Generalista), um sistema flexível, capaz de aprender a resolver qualquer tarefa.

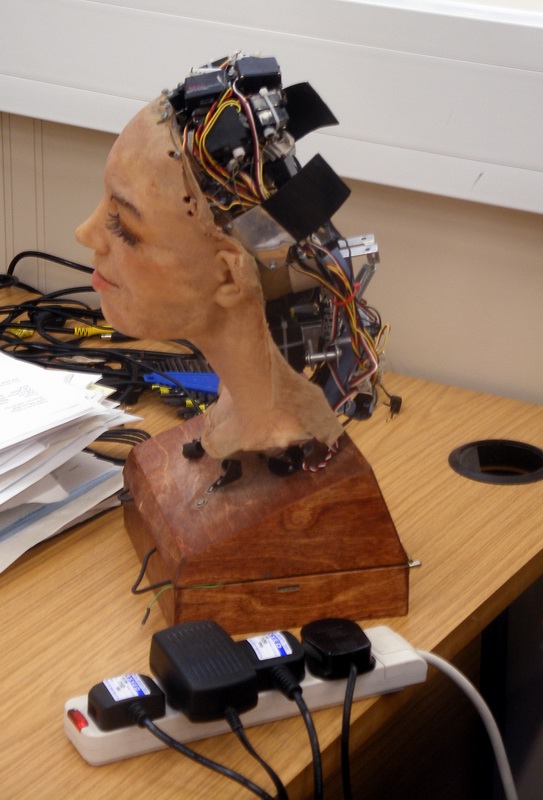

É intuitivo. Os únicos sistemas que conhecemos como capazes de aprender somos nós mesmos. O ser humano é a única coisa capaz de dominar uma linguagem e desenvolver modelos formais do mundo ao seu redor. Uma IA forte seria um cérebro eletrônico, uma cópia de nós mesmos, e um primeiro passo seria desenvolver soluções especializadas para pequenos problemas, como o jogo de xadrez.

Apesar de ainda estamos muito longe das AGIs, a IAjá é usada em diversas aplicações. O autocompletar do celular, impressão 3D, video-games, animações e até as buscas na internet usam sistemas capazes de aprender, algoritmos que mudam e se complexificam com o tempo.

Em 1950, Alan Turing propôs no artigo “Computing Machinery and Intelligence” o “jogo da imitação” (também chamado de Teste de Turing). Para Turing, como não temos um modelo completo de como uma inteligência funciona, não é possível avaliar se uma máquina é realmente capaz de pensar. A questão para avaliar uma IA, então, não poderia ser se a máquina realmente entendesse o mundo ao seu redor, pois ela simplesmente poderia aprender apenas a responder os testes que propomos para ela, sem ter uma inteligência de verdade. Precisaríamos de um artifício, de uma situação na qual pudéssemos comparar a capacidade de uma pessoa e de uma máquina aprenderem sobre uma tarefa. A solução? Fazê-la imitar um ser humano.

O jogo é simples, um entrevistador conduz uma entrevista simultânea com duas pessoas, mas uma delas é um computador tentando se passar por um ser humano. Assim, ele ganharia o jogo se o entrevistador não conseguisse diferenciá-lo do outro entrevistado, enquanto os seres humanos deveriam colaborar para tentar fazê-lo se revelar. As pessoas poderiam, por exemplo, pedir para que um cálculo fosse feito de cabeça, já que o computador poderia fazer um cálculo exato, enquanto e o ser humano traria arredondamentos. Seria possível o computador simular erros e trejeitos que confundissem o entrevistador? Seria possível ele improvisar e mentir?

Nos primórdios da computação, se imaginava que o ser humano era a medida de inteligência. Enganá-lo, então, deveria ser uma das coisas mais difíceis de se fazer.

O Teste de Voight-Kampf

É a primeira cena do filme Blade Runner. Uma sala de arquitetura labiríntica é iluminada por uma luz azul. Mesas e computadores indicam que estamos em um escritório futurista, mas um ventilador de teto e uma densa névoa que preenche a sala destoam. Um homem convida outro para sentar à mesa, é uma entrevista para uma vaga de trabalho. Antes da conversa começar, o entrevistador liga um aparelho arcano, um braço mecânico se estende, na sua ponta uma câmera, uma lente iluminada que foca as pupilas do entrevistado como uma macabra lente vermelha. Um fole bombeia, a máquina respira, as perguntas começam.

“Você está num deserto, caminhando pela areia, quando você encontra uma tartaruga se arrastando na areia. Você se abaixa e a vira. A tartaruga está de costas, sua barriga cozinha no Sol forte, chutando desesperadamente para se virar, mas não ela consegue. Não sem a sua ajuda. Mas você não vai ajudá-la. Por que você não vai ajudá-la?”

O teste de Voight-Kampf foi descrito por Philip K. Dick no livro “Com o que sonham as Ovelhas Elétricas?”, e adaptado para o cinema em Blade Runner, era uma versão do Jogo da Imitação, usado para verificar se alguém é uma pessoa de verdade ou um androide replicante. Segundo a história, replicantes imitam com perfeição os seres humanos, possuindo a mesma estrutura física, mas são mais fortes, mais rápidos e mais inteligentes. Só que eles são criados em tanques de crescimento rápido e, por possuírem poucas memórias, suas reações emocionais traem a sua natureza. Eles não são tão sensíveis à crueldade quanto nós, suas reações ao estresse são diferentes, e eles não entendem a crueldade. Ao invés de expressar preocupação quanto ao sofrimento da tartaruga, um replicante simplesmente ficaria confuso com a situação.

Turing imaginava que, mesmo que não haja um limite para o poder de trabalho dos computadores (que, em teoria, podem trabalhar com infinitos números), a inteligência humana precisaria de influências “colaterais”. O princípio da dor e do prazer, o instinto, a memória, haveria algum princípio que precisaríamos programar nas máquinas para que elas pudessem aprender de forma autônoma, como nós. Computadores são ferramentas bastante simples, capazes apenas de executar um programa, seguir um conjunto de instruções criado pelo seu programador. Em teoria, eles são muito mais potentes do que as pessoas, pois podem realizar bilhões de operações por segundo sobe conjuntos de dados gigantescos, mas nós não sabemos, mesmo, até que ponto nossos programas são capazes de compreender tudo o que acontece ao nosso redor (problemas como a relação P e NP, ou o teorema da incompletude de Gödel fundamentam estas dúvidas). Esta seria uma fronteira entre o artificial e o natural, um desconhecido que é ilustrado pelo teste de Voight-Kampf.

Dessa forma, um cérebro eletrônico talvez possa simular o nosso, mas haveriam fronteiras claras. Ele seria incapaz de sentir emoções, ele seria uma inteligência puramente verbal e literal, seria dotado de uma frieza mecânica, ou de um tique nervoso. A natureza da máquina sobreporia a programação humana que nós lhe damos. Talvez ela fosse desprovida de emoções, ou incapaz de inovação, ela não poderia criar.

Há modelos de inteligências artificiais como sistemas especialistas, sistemas de descoberta de conhecimento, data mining e redes neurais, todos são formas artificiais de raciocínio que geram resultados muito interessantes, mas não se parecem em nada com pessoas.

A ficção científica está repleta de mentes artificiais e alienígenas. O Data, de Jornada nas Estrelas, era um androide curioso, mas incapaz de sentir emoções complexas. O Bishop, do filme Aliens, o Resgate, se comportava sempre de uma forma submissa às pessoas, possuindo regras complexas que sempre deveria obedecer. O Exterminador do Futuro era uma máquina de extermínio que “vestia” uma pessoa, tinha um frio esqueleto metálico movendo um corpo de carne. Mas a fronteira entre humanos e máquinas se baseia em um princípio que coloca todos seres humanos como iguais, seres pensantes capazes de se reconhecer. Sozinha no plano da racionalidade, a humanidade olha para os animais e sabe que eles não tem alma porque não conseguem pensar como nós. Sendo fundamentalmente diferente, nós reconhecemos os iguais. Nossa inteligência é a única capaz de ver a realidade em si, o único espelho do mundo. Naturalmente, a mente sempre seria capaz de se reconhecer.

Os robôs conversadores

Em 1966, provavelmente enquanto Philip K. Dick escrevia seu livro, alguns estudantes do MIT usavam o gigantesco computador IBM 7094 da universidade para interagi com um pequeníssimo programa (para os nossos padrões de hoje). A ELIZA era uma simulação de uma psicoterapeuta, para interagir com ela, ela fazia perguntas que você respondia no terminal. Baseando-se nas suas respostas, ela continuava a conversa. Algumas de suas frases incluíam:

“Falem-me mais sobre isso.”

“O que você pensa sobre <assunto>.”

“Você está muito negativo sobre isso.”

Joseph Weizenbaum, um professor do MIT, escreveu a ELIZA para aplicar os conceitos que estudava de expressões regulares e também mostrar o quão simples poderia ser construir uma interface entre homens e máquinas (você pode testar o programa aqui). Mas a longevidade da ELIZA mostra um experimento muito além do seu pressuposto, muitos alunos achavam que a conversa com o sistema era reconfortante, gostaram da experiência. Weizenbaum, já sem muita criatividade, chamou essa sensação de Efeito ELIZA.

O ELIZA em Python possui menos de 300 linhas de código, incluindo o parser para análise do que é digitado. Ele faz uma análise muito simples das frases que lhe são ditas, e suas respostas são um tanto aleatórias. Mesmo assim, esse programa bastante simples continua a surpreender estudantes de computação e psicologia pela sua capacidade de produzir empatia. A mente pode se reconhecer, mas será que é necessário que ela se reconheça para que trate o outro com empatia?

Os Tuítes e as Infodemias

Os cucos são uma espécie bastante popular de pássaros que esconde uma história de terror: Eles são pássaros parasitários, que colocam seus ovos no ninho de outras aves. Seus filhotes, muito maiores do que os de suas vítimas, empurram seus “irmãos” para fora do ninho. O mais estranhos é que os pais adotivos continuam a alimentar o cuco. Não sei o porquê, talvez o instinto familiar é mais forte, ou se eles simplesmente não conseguem reconhecer que o bebê gigante não é seu.

Quase cinquenta anos se passariam desde que o “efeito ELIZA” foi observado pela primeira vez, quando, na década de 2010, um movimento chamado “Primavera Árabe” começava a desafiar cientistas sociais e teóricos políticos. Mohamed Bouazizi era um comerciante ambulante da cidade de Ben Arous, na Tunísia, até que teve os seus bens confiscados pela polícia. Ele resolveu ir à prefeitura reclamar, e, quando não foi atendido, ateou fogo a si mesmo. Os vídeos rapidamente circularam, despertando o clamor popular. Em apenas quatro semanas de protestos o governo caiu,e isso despertou uma série de protestos pelo Oriente Médio. Como uma cidade com menos de cem mil habitantes seria o berço de um movimento que se espalharia por uma dúzia de outros países? A única coisa clara era uma nova tecnologia nascente no cerne dos protestos: as redes sociais.

A Primavera Árabe abriu a década na qual as redes sociais se tornaram centrais nas nossas vidas políticas. Em 2014, o Facebook implementou uma notificação de “votei”, que permitia uma pessoa dizer que participou das eleições, já que nos EUA não é obrigatório votar. Segundo Zuckberg, isso incentivaria as pessoas a votar, aumentaria a participação democrática. Era um vislumbre de como a internet se tornaria o centro da nossa vida política. As pessoas estavam usando as redes para se comunicar mais, trocando informações em um nível nunca visto.

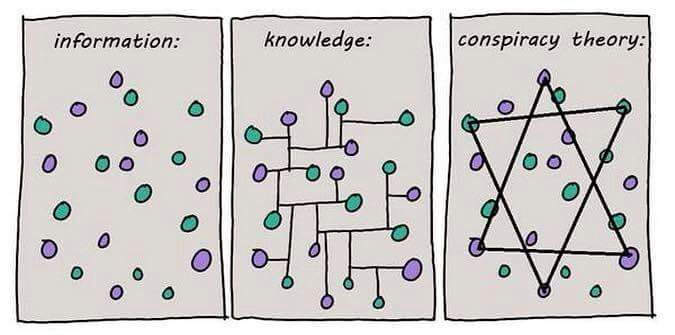

Em 2016, a campanha pelo Brexit trouxe à tona um lado inesperado na política das redes sociais. Sistemas de profiling em larga escala, conduzidos por empresas como a Cambridge Analytica e AggregateIQ, foram essenciais no “marketing de precisão” que conseguiu trazer 3 milhões de novos eleitores para o referendo (se compararmos os eleitores que participaram do referendo com os da eleição de 2014). O “algoritmo” parecia domar a potencialidade explosiva das redes sociais, as massas novamente se mostravam influenciáveis, e um novo termo surgia: fake news disparadas por targeted marketing. Notícias falsas como propaganda direcionada, elas falam exatamente o que você quer ouvir; aquilo que vai te causar uma forte reação. Estas notícias eram criadas por grupos de marketing, pessoas treinadas em buscar formas de afetar tanto a mente, quanto o coração do público.

Nas eleições de 2018, os grupos de whatsapp tomaram a proeminência dessas redes de targeted marketing. O sistema começava, pelo menos no Brasil, a caminhar por suas próprias pernas, e qualquer ponto de vista pode ser sustentado na torrente informacional.. Mensagens das mais bizarras espalham o pânico e a desinformação, formando poderosos blocos políticos. Quanto mais visceral, maior o alcance. Isso não é de se surpreender, vendo a visibilidade que grupos anti-vacinas e terraplanistas ganharam. As pessoas se tornando tão seletivas com as notícias que leem que alguns chegaram a teorizar que vivemos em uma era da pós-verdade, onde há tanta informação que fica difícil, senão quase impossível, termos um entendimento comum do que existe e o que não existe. Enquanto escrevo este texto, um grande pânico se espalha sobre o vírus nCov-19 que se alastra pela China, tão grande que a Organização Mundial de Saúde já a chama de “infodemia”.

E um dos agentes principais dessa era são os bots, aqueles nossos contatos nas redes sociais que espalham as suas mensagens, seja repassando-as, seja ativamente invadindo outros espaços, como caixas de comentários. Essa segunda geração dos chatbots são programas que habitam as redes sociais, interagindo com as pessoas para oferecer informações e serviços, enquanto coletam dados dos usuários. Se você controla uma rede de bots, tem acesso a todas as pessoas indiretamente conectados à eles. Mas nem todos os bots são programas, muitos são pessoas que divulgam notícias ou desinformação, fazem ativismo e até atacam outros, voluntariamente, ou como um trabalho (content farms e click farms são apenas alguns exemplos de negócios construídos sobre esta lógica).

Sejam programas avançados ou simplesmente trabalhadores ou pessoas muito engajadas, os bots se tornaram uma parte essencial da vida política da rede, são o centro da viralidade. Isso se tornou um problema, já que a tecnologia-chave desse imenso sistema social da internet é a medida da relevância do conteúdo. Palavras são pesadas pelo quanto elas são usadas, pelo quão único e importante é o seu significado, e pelo quanto elas estão sendo citadas no momento pelos usuários. Bots podem alterar a relevância de uma mensagem, que complementa a sua viralidade. A chave não é o conhecimento, mas a emoção. Se as mensagens dizem o que queremos ouvir, se elas reforçam nossas ideias, se elas parecem nos ameaçar, nós as repassamos ou reagimos a ela (algo equivalente a repassá-la). Nós simplesmente não temos tempo ou interesse em checar as fontes de tudo que recebemos, ainda mais se a mensagem nos parece algo urgente. E assim como as vítimas dos cucos, quando recebemos a informação que nos agrada, cuidamos dela com muito esmero. Todos nós temos uma reputação a zelar, e nossas opiniões, mesmo que não tenham lá muito fundamento, não podem ser publicamente ridicularizadas.

Neste mundo de bots, pessoas e programas são indistinguíveis, e suas redes organizam, informalmente, grupos e subculturas. Turing esperava que os computadores poderiam se passar por seres humanos, mas precisariam de uma grande habilidade para nos enganar. A verdade é que muitas vezes nós queremos ser enganados. Parece que o jogo da imitação foi solucionado.